TECH M

TECH M

복잡해진 세상, 빛 발하는 청각 인터페이스

| 맥북 프로의 오디오 시스템 |

‘댕’. 이 글을 쓰기 위해 맥북 프로 노트북을 켜니 웅장한 소리와 함께 컴퓨터가 가동한다. 매킨토시를 사용하는 사용자라면 누구든지 이 소리만 듣고도 컴퓨터가 켜졌다는 사실을 파악할 수 있다. 하지만 최근 출시된 신형 맥북 프로에서는 초기의 매킨토시에서부터 이어져온 이 기동음이 사라졌다고 한다.

애플을 사랑하는 많은 사용자 사이에서는 매킨토시의 전통이 사라졌다는 불평도 나오고 있다. 단 몇 초짜리의 순간적인 소리가 컴퓨터의 시동을 알리는 메시지를 사용자에게 전달한다는 사실을 넘어, 전 세계 최고 브랜드 가치를 다투는 애플의 상징으로 까지 여겨지기도 한다.

애플의 상징이 된 매킨토시 기동음

사람과 컴퓨터 사이의 소통을 연구하는 학문인 HCI(Human Computer Interaction)에서는 이런 소리를 ‘이어콘(earcon)’이라고 한다. 이어콘은 간결하면서도 특징적인 소리를 통해 컴퓨터의 상태나 정보를 사용자에게 제공한다.

우리가 컴퓨터 화면에서 매일 보고 사용하고 있는 ‘아이콘(icon)’의 어원이 눈을 뜻하는 ‘eye’에서 착안된 ‘eyecon’에서 유래되었다는 것을 생각해보면 좀 더 이해가 쉬울 것이다. 다시 말해 시각을 통해 인터랙션 하는 GUI(Graphic User Interface)에서 아이콘이 있다면, 청각 인터페이스에서는 이어콘이 그 기능을 하는 것이다.

우리는 컴퓨터를 보는 데 익숙하다. 하지만 디스플레이 속의 복잡한 시각 정보를 보고 조작하는 데 우리의 작업 기억(working memory)은 부하 상태에 빠지기 쉽다.

특히 컴퓨터나 스마트폰에서 눈으로 보는 아이콘만으로는 해당 아이콘이 무엇을 뜻하는지 선뜻 알기가 쉽지 않다. 하지만 연구에 따르면, 시각 정보인 아이콘과 청각 정보인 이어콘을 동시에 제공하면 아이콘에 담긴 정보를 보다 효과적으로 인지한다고 한다. 우리는 컴퓨터를 보고 들음으로써 보다 빠르고 정확하게 사용할 수 있는 것이다.

또 가전제품이나 사물인터넷(IoT) 기기 등 시각 디스플레이가 제한적이거나 없을 경우 청각 인터페이스는 효과적으로 작동한다. 에어컨이 동작할 때 ‘띠리링’ 하며 기기가 켜지는 소리나, 주방의 가스 알람 센서에서 요란한 경고음으로 알림을 주는 것이 그 예이다.

더 나아가 청각 인터페이스는 우리의 시각을 자유롭게 하기도 한다. 요리로 바쁜 주방에서 밥이 다 됐다는 것을 알리기 위해 전기밥솥이 스스로 밥이 다 됐다고 소리로 알려주거나, 운전 중 내비게이션이 소리로 지시사항을 알려줌으로써 우리는 시각 자원을 소비하지 않고도 방해 없이 요리나 운전 주행과 같은 주 과업을 수행할 수 있다.

이어콘 뿐만이 아니다. 우리는 귀를 통해 복잡한 정보를 볼 수도 있다. 복잡한 주차장에서 자동차를 후진 주차할 때 다른 자동차나 장애물과 가까워지며 충돌하려 하면 ‘삐삐삐삐’ 하며 요란한 비프(beep)음을 내며 경고하는 상황을 경험해본 적이 있을 것이다.

이는 자동차 내의 컴퓨터가 센서를 통해 인식한 자동차와의 거리 정보를 비프음을 재생하는 빠르기로 매핑해 운전자에게 정보를 디스플레이 한 것이다. 이러한 기술을 소니피케이션(sonification)이라고 한다.

인간의 청각은 소리의 시간적 변화나 크기, 높낮이의 변화, 그리고 공간적 변화를 알아채는 데 높은 해상력을 갖고 있다. 소니피케이션은 이러한 신체의 이점을 활용해 정보를 소리의 빠르기 혹은 멜로디, 음량 등에 매핑해 디스플레이 하는 기술이다.

더불어 청각 인터페이스는 자동차 주행과 같이 이미 시각적으로 인지 과부하인 상황에서 긴급하고 중요한 정보를 사용자에게 디스플레이 하는 데에도 효과적이다. 앞에서 언급한 충돌방지 알람 시스템이나, 속도 위반시 혹은 차선 이탈시 소리로 알림을 주는 청각 인터페이스는 운전자의 시각을 자유롭게 하여 안전한 주행 과업을 수행토록 한다.

소니피케이션의 예는 자동차뿐만이 아니라 가깝게는 우리 주변의 병원부터 잠수함의 소나(sonar) 시스템과 같은 군사기술, 그리고 우주과학까지 다양한 분야에 적용돼 있다.

병원 응급실에서 들을 수 있는 환자의 생체 모니터 시스템은 컴퓨터를 통해 환자의 맥박 정보를 비프음 재생의 빠르기로 매핑하고, 긴급 상황 시 경고음을 내는 등 환자의 상태를 소리로 의료진에게 들려준다. 여러 환자를 돌보며 긴급한 상황에 바로 대응해야 하는 이미 정신없는 상태의 의료진에게 환자의 정보를 효과적으로 파악할 수 있는 방법은 바로 그들의 ‘귀’인 것이다.

우주 과학에서는 천체 장비를 통해 수집한 복잡한 정보를 소리로 매핑해 분석하기도 한다. 우주에서 들어오는 엄청난 양의 정보들을 시야각이 한정된 눈으로 관찰하며 특이점을 찾아내기란 쉽지 않다.

하지만 우주과학자들은 그 복잡한 정보들을 소니피케이션을 통해 박자, 음정 등에 매핑해 소리로 만들어 한 번에 관찰할 수 있도록 한다. 2007년 미 항공우주국(NASA)에서는 태양폭풍에서 수집한 방대한 데이터를 소니피케이션을 통해 오디오로 만들어 태양 플라즈마의 흐름을 관찰하기도 했다.

| VR기기 오큘러스 리프트를 사용하고 있는 모습 |

청각 인터페이스, 가상현실 몰입감 좌우

최근 각광받고 있는 분야인 가상현실 기술에도 청각 인터페이스는 중요한 역할을 하게 된다. 가상현실에 몰입할 수 있는 환경을 만드는 데에는 사용자에게 실재감(presence)을 부여하는 것이 중요하다. 시각 환경에서는 ‘오큘러스(Oculus)’나 ‘삼성 기어VR’와 같은 HMD(Head-mounted Display)의 보급으로 사용자들은 예전과는 다른 차원으로 가상현실에 몰입할 수 있게 되었다. 하지만 청각 인터페이스가 더해진다면 그 몰입은 더욱 깊어진다.

우리는 공간을 인지할 때 시각기관뿐만 아니라 청각기관을 사용한다. 귀를 통해 공간을 듣는 셈이다. 청각을 통한 공간 인지(spatial cognition) 기능을 통해 우리는 소리가 어디서 났는지를 인지할 수 있는데, 이러한 능력을 음원 위치화(sound localization)라고 한다. 소리는 음원에서부터 음파의 형태로 우리의 양쪽 귀로 전달된다.

하지만 음원은 사람으로부터 떨어져 있는 위치적 특성과 공간의 환경적 특성 때문에 양쪽 귀에 시간차(time-difference)와 음량차(level-difference)를 갖고 도달한다.

간단하게 예를 들어보자면 정육면체의 가운데에 사람이 있고, 사람을 기준으로 대각선 방향의 꼭지점에서 개가 짖었다고 가정하자. 그 소리의 음원으로부터 우리의 왼쪽 귀와 오른쪽 귀의 거리는 미세한 차이가 있다. 여기서 소리의 시간차와 음량차가 발생한다. 그리고 정육면체라는 공간의 특성 때문에 소리라는 파동 에너지는 벽에 이리저리 반사되어 우리의 양쪽 귀에 도달하게 된다.

우리의 뇌는 이러한 단서들을 바탕으로 음원의 위치와 정육면체라는 공간적 특성을 인지한다.

가상현실에서 청각 시스템을 물리적, 신체적으로 잘 시뮬레이션해 인간의 음원 위치화(sound localization) 능력을 발휘하게 한다면 사용자는 시각에 청각이 더해져 공간을 현실적으로 인지하게 될 것이다. 그리고 이는 높은 실재감을 부여하여 가상현실에 더욱 몰입할 수 있는 환경을 만드는 데 큰 도움이 될 것이다.

>>>

사용자는 늘어난 기기에서 받는 정보량이 증가해 인지부하 상태에 빠질 것이다.

이러한 환경에서 청각 인터페이스는 정보의 와해성을 줄이고

여러 기기들과 인터랙션 할 수 있는 효과적인 도구다.

앞에서 알아본 바와 같이 청각 인터페이스는 이미 많은 기술이 발전되었으면서도 인지적 과부하 상태인 시각 인터페이스를 효과적으로 도울 수 있다. 또 복잡한 정보를 음악적인 특성을 활용하여 알기 쉽게 분석하기도 하고 공간 인지에도 큰 도움이 된다.

나아가 청각 정보는 우울함이나 행복함 등 감정적인 정보를 전달할 수도 있다고 한다. 스마트폰이나 스마트워치 같은 모바일 기기가 일상화되고, 웨어러블 기기와 사물인터넷 기기도 점차 증가하고 있는 추세다. 개별 기기의 시각 디스플레이는 작아지거나 장착할 수 없는 환경이 되어 시각 정보를 표시하는 데 한계가 있다.

그리고 기기의 숫자가 증가하면서 사용자가 받는 정보의 양은 증가하여 인지부하 상태에 빠질 것이다. 이러한 환경에서 청각 인터페이스는 정보의 와해성을 줄이고 여러 기기들과 인터랙션 할 수 있는 효과적인 도구가 될 것이다.

<본 기사는 테크M 제44호(2016년 12월) 기사입니다>

-

'전자정부 名家' LG CNS, 1200억 '행복e음' 사업 수주로 자존심 회복할까공공 소프트웨어(SW) 사업의 강자 LG CNS가 올해 공공시장 첫 '대어'로 꼽히는 보건복지부 차세대 사회보장정보시스템(행복e음) 구축 사업에 출사표를 던졌다.17일 업계에 따르면 LG CNS는 이날 행복e음 사업 재입찰에 제안서를 제출했다.행복e음 사업은 지난 2009년 복지부가 각종 사회복지 급여 및 서비스 지원 대상자의 자격과 이력에 관한 정보를 통합 관리하기 위해 구축한 시스템을 현대화 하는 사업이다. 올해부터 3년간 약 1220억원이 투입된다.이 사업은 지난 3일 첫 입찰 공고를 마감했으나 무2020-03-17 16:54:47테크M 남도영 기자

'전자정부 名家' LG CNS, 1200억 '행복e음' 사업 수주로 자존심 회복할까공공 소프트웨어(SW) 사업의 강자 LG CNS가 올해 공공시장 첫 '대어'로 꼽히는 보건복지부 차세대 사회보장정보시스템(행복e음) 구축 사업에 출사표를 던졌다.17일 업계에 따르면 LG CNS는 이날 행복e음 사업 재입찰에 제안서를 제출했다.행복e음 사업은 지난 2009년 복지부가 각종 사회복지 급여 및 서비스 지원 대상자의 자격과 이력에 관한 정보를 통합 관리하기 위해 구축한 시스템을 현대화 하는 사업이다. 올해부터 3년간 약 1220억원이 투입된다.이 사업은 지난 3일 첫 입찰 공고를 마감했으나 무2020-03-17 16:54:47테크M 남도영 기자 -

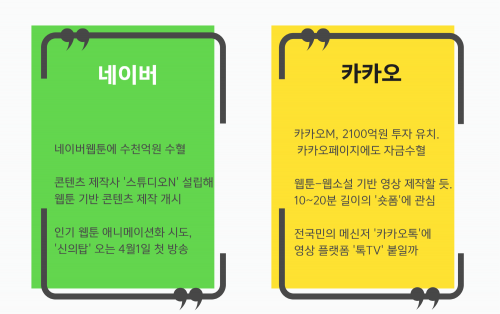

네이버 vs 카카오, 포털-메신저 이은 3라운드... 링은 '콘텐츠'#수천억 자금으로 뭘 만들까#넷플릭스 잡을 수 있을까#톡TV-네이버TV 경쟁 볼만할 듯국내 대표 인터넷 맞수 기업 네이버와 카카오의 세번재 경쟁 무대 막이 올랐다. 포털과 메신저 플랫폼에서 치열하게 경쟁해온 두 기업의 3라운드 링은 '콘텐츠'다. 이미 양사는 콘텐츠 자회사에 수천억원의 자금을 쌓아놨다. 올해부터 본격적으로 콘텐츠 양산에 돌입한다. 콘텐츠 주도권 경쟁의 전초전은 이미 시작됐다.◆실탄 마련한 카카오M, 직접 콘텐츠 제작 개시카카오는 지난 16일 콘텐츠 자회사 카카오M이 3자 배정 유상증자2020-03-17 15:53:45테크M 허준 기자

네이버 vs 카카오, 포털-메신저 이은 3라운드... 링은 '콘텐츠'#수천억 자금으로 뭘 만들까#넷플릭스 잡을 수 있을까#톡TV-네이버TV 경쟁 볼만할 듯국내 대표 인터넷 맞수 기업 네이버와 카카오의 세번재 경쟁 무대 막이 올랐다. 포털과 메신저 플랫폼에서 치열하게 경쟁해온 두 기업의 3라운드 링은 '콘텐츠'다. 이미 양사는 콘텐츠 자회사에 수천억원의 자금을 쌓아놨다. 올해부터 본격적으로 콘텐츠 양산에 돌입한다. 콘텐츠 주도권 경쟁의 전초전은 이미 시작됐다.◆실탄 마련한 카카오M, 직접 콘텐츠 제작 개시카카오는 지난 16일 콘텐츠 자회사 카카오M이 3자 배정 유상증자2020-03-17 15:53:45테크M 허준 기자 -

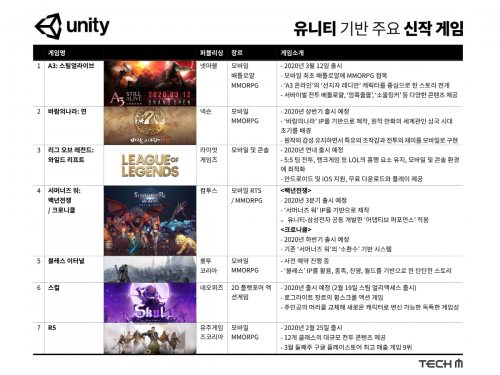

[템 사이트] 게임 하면 유니티! 2020년 기대되는 유니티 기반 게임은?연일 쏟아지는 신작 소식이 게이머들을 설레게 하고 있습니다. 남다른 스케일을 자랑하는 게임업체들의 대형 신작은 물론 독특한 게임성을 내세운 게임까지, 게이머들의 다양한 취향을 만족시킬만한 다양한 신작게임들이 많습니다.오늘은 특히 유니티 엔진을 기반으로 한 신작 게임들을 엄선해서 소개할까 합니다. 유니티는 이미 전세계 수백만명의 게임 개발자들이 사용하는 유명한 게임엔진입니다. 최신 버전의 엔진 '유니티 2019.3' 업데이트를 통해 260가지가 넘는 개선사항과 신규 기능이 포함돼 진일보한 고성능 그래픽과 최적화 기2020-03-17 15:30:39테크M 허준 기자

[템 사이트] 게임 하면 유니티! 2020년 기대되는 유니티 기반 게임은?연일 쏟아지는 신작 소식이 게이머들을 설레게 하고 있습니다. 남다른 스케일을 자랑하는 게임업체들의 대형 신작은 물론 독특한 게임성을 내세운 게임까지, 게이머들의 다양한 취향을 만족시킬만한 다양한 신작게임들이 많습니다.오늘은 특히 유니티 엔진을 기반으로 한 신작 게임들을 엄선해서 소개할까 합니다. 유니티는 이미 전세계 수백만명의 게임 개발자들이 사용하는 유명한 게임엔진입니다. 최신 버전의 엔진 '유니티 2019.3' 업데이트를 통해 260가지가 넘는 개선사항과 신규 기능이 포함돼 진일보한 고성능 그래픽과 최적화 기2020-03-17 15:30:39테크M 허준 기자