TECH M

TECH M

음성에서 이미지, 센서로… AI 인터페이스의 변신

인공지능에서 기술적으로 중요한 것은 사용자의 의도를 파악하고, 분석 결과를 사용자에게 전달하는 것이다.

기업 입장에서는 인공지능이 사람을 대신해 효과적으로 고객과 커뮤니케이션 할 수 있는지가 중요하다.

현재 인공지능은 대부분 음성 인터페이스 기반이다. 언어라는 커뮤니케이션이 가장 보편적이기 때문이다.

이미지 기반의 인공지능이 발전하면 제스처나 표정을 통해 사용자의 의도를 파악할 수 있다.

또 센서 인터페이스에 의한 인공지능으로 진화하면 스마트 워치에 저장된 사용자의 신체 데이터를 자동 전송하고 신체를 스캔해 인공지능이 진단하게 될 것이다.

최근 해외 뉴스에서 인공지능(AI)과 관련한 인상적인 소식 두 가지가 전해졌다.

첫 번째는 구글이 개발한 인공지능 음성비서인 구글 어시스턴트를 탑재한 인공지능 스피커 ‘구글 홈(Google Home)’에 대한 소식이고, 또 한 가지는 구글 홈에 앞서 세상에 선보인 ‘아마존 에코(Amazon Echo)’에 관한 것이다.

구글홈 이벤트와 에코 해프닝

미국의 게임 영상 중계 사이트인 트위치(www.twitch.tv)는 구글 홈 두 대가 서로 대화하는 ‘인공지능 스피커의 대화’를 실시간으로 중계했다.

사무엘 베케트의 소설 ‘고도를 기다리며’에 등장하는 인물인 ‘블라디미르’와 ‘에스트라곤’으로 이름이 붙여진 두 대의 인공지능 스피커는 사람과 대화하며 말하는 법을 배우는 ‘클레버봇’이란 소프트웨어를 탑재하고 대화하면서 중계를 이어갔다. 세계에서 350만 명이 넘는 시청자가 이들의 대화를 지켜봤다.

![게임 영상 중계 사이트 트위치에서 실시간 중계된 ‘구글 홈’ 두대의 대화 모습 [자료: twich.tv]](http://techm.kr/data/editor/1701/1981902326_1485149197.04225.png)

아직까지는 동문서답이 주를 이뤄 튜링 테스트를 통과할 만큼 체계적인 대화를 이어가지 못했지만 ‘알파고’가 보여줬듯이 대용량 데이터가 누적되면 어느 순간 인간인지 인공지능인지 구별할 수 없는 정도에 도달할 것이다.

또 더 시간이 지나면 스스로 감정까지 갖고 아이덴티티(identity)를 인식하는 ‘초지능’으로 발전할 것이다.

또 한 가지 소식은 TV에서 나오는 소리를 에코가 주인의 명령으로 알아듣고 자신이 소속된(?) 아마존에 고가의 장난감을 주문한 해프닝이었다.

미국 댈러스에 사는 6살짜리 소녀가 에코에게 자신이 원하는 장남감인 ‘인형의 집’과 쿠키를 주문하라고 말했고, 에코는 충실하게 주인인 소녀의 명령을 수행했다.

진짜 해프닝은 이 사건을 보도한 앵커가 뉴스 시간에 “알렉사 나도 인형의 집을 주문해줘(Alexa, order me a dollhouse)”라고 말 한 것이다.

앵커의 멘트가 각 집의 TV로 방송되자 미국 전역에서 에코가 주인의 목소리로 오인하고 장난감을 주문하기 시작했다.

아마존의 에코는 프리퍼런스(preference) 설정에서 음성으로 주문하는 것을 막거나 주문 후 인증코드를 다시 한 번 확인할 수 있지만, 이 설정을 해 놓지 않은 에코들이 앵커의 명령을 그대로 실행한 것이다.

![뉴스 앵커가 TV 뉴스에서 “알렉사 나도 인형을 주문해줘”라고 말하자 아마존 에코가 미국 전역에서 장난감을 주문하는 헤프닝이 벌어졌다. [자료: CW6 News]](http://techm.kr/data/editor/1701/1981902326_1485149254.80018.png)

에코는 상황인식 스피커

우리가 편의상 인공지능 스피커인 에코를 ‘음성인식 스피커’라고 부르지만, ‘상황인식 스피커’라고 보는 것이 맞다.

아마존 에코는 사람이 말을 하면 우선 음성인식(Voice Recognizing)을 하고 상황인식(Context Awareness)을 한 후 판단해 실행(Order)을 한다.

기능적으로 음성인식은 사람이 말을 한 것을 텍스트로 바꾸는 과정을 말하며, 이미 10년도 더 전에 음성인식 전문회사인 뉘앙스커뮤니케이션에 의해 완성된 기술이다.

뉘앙스는 음성인식 엔진으로 ‘아이폰’에 탑재한 ‘시리’부터 구글의 음성검색, 보이스 키보드뿐 아니라 미국 국가안보국(NSA)같은 곳에서 감청 프로그램에 사용할 정도로 강력한 음성인식 엔진이다.

물론 아직 한국어의 경우 영어보다 인식률이 떨어지지만 90%에 가까운 인식률을 보여주고있다. 북미 표준영어의 경우 거의 정확하게 받아 적는다.

>>>

이미지 기반의 인공지능이 더욱 발전하면 카메라를 통해 사람을

인식하는 것뿐 아니라 제스처나 표정을 통해 사용자의 의도를 파악할 수도 있다.

에코에서 인공지능이 필요한 부분은 음성을 인식하는 부분이 아니라 인식한 음성의 문맥의 의미를 파악하고 어떤 행동을 수행해야 하는지 결정하는 부분이다.

에코 해프닝에서 보여줬듯 아직 주인의 명령인지 TV에서 나오는 소리인지를 구별하는 부분까지는 인공지능이 사용되지 않고 있다.

하지만, 이러한 보안상의 허점 역시 성문분석 등의 기술 등을 추가하면 충분히 보완할 수 있다.

인공지능에서 기술적으로 가장 중요한 부분은 사용자의 의도를 정확하게 파악하고, 분석 결과를 사용자에게 어떻게 효과적으로 전달하느냐다.

기업 입장에서는 비즈니스를 위해 인공지능이 시스템의 지능화, 자동화, 무인화 등을 통해 사람들을 대신해 효과적으로 고객과 커뮤니케이션 할 수 있는지가 중요하다.

실제로 IBM의 인공지능 ‘왓슨(Watson)’은 국내 대형병원인 가천대 길병원에서 사용되기 시작했다. 왓슨은 가천대 길병원에서 의사의 암환자 진단과 치료를 보조하는 역할을 담당한다. 왓슨은 사람의 언어를 이해하고 근거 자료를 기반으로 가설을 제안하고 학습이 가능하다.

환자의 각종 임상정보를 입력하면 의료 데이터를 감지하고 분석, 이해한 다음 수집된 데이터를 근거로 가설을 세워 입증하고 의사에게 조언한다.

한국IBM이 국내의 한 기업과 한국어가 가능한 버전의 왓슨을 준비하고 있으나 이번 도입은 IBM 본사에서 진행한 것으로 영문 버전의 왓슨이 지원하다.

왓슨이 콜센터 상담직원을 대신 할 수도 있다.

아웃도어 의류업체 노스페이스는 왓슨 기반의 ‘플루이드 엑스퍼트 퍼스널 쇼퍼(Fluid Expert Personal Shopper)’ 앱을 개발해 고객이 쇼핑하면서 궁금한 사항들을 왓슨에게 질문하고 이를 분석해 고객의 구매결정에 도움을 줄 수 있는 서비스를 제공하고 있다. 호주 ANZ은행은 왓슨을 이용해 많은 시간을 소비하는 자산관리 분석을 빠르게 수행한다.

우리가 현재 실생활에서 접하고 있는 인공지능은 대부분 음성이라는 인터페이스를 기반으로 하고 있다.

애플의 시리, 삼성의 ‘S보이스’, SK텔레콤의 ‘누구(nugu)’, 마이크로소프트의 ‘코타나(Cortana)’, 아마존의 에코, 구글의 음성검색과 구글 홈.

음성 기반의 인터페이스가 현재 사실상의 표준(de facto standard)이 된 것은 뉘앙스커뮤니케이션의 공이 지대한 것뿐 아니라 사람들의 특성상 언어라는 커뮤니케이션이 가장 보편적이기 때문이다.

휴대폰의 발전과정을 봐도 음성통화 서비스가 먼저 구현되고 (물론 영상통화가 가능한 기술적인 조건들이 나중에 충족되기는 했지만) 그 이후 영상통화가 생겨났다.

그런 맥락에서 보자면 음성 다음에는 사진이나 그림을 기반으로 한 인공지능이 대세를 이루게 된다.

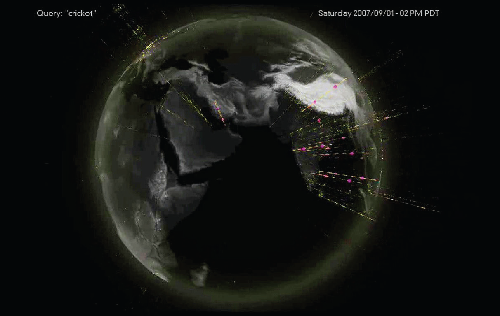

구글은 영국 에든버러에서 열린 ‘머신러닝 국제학회’에서 고양이 얼굴 인식 실험 결과를 발표했다.

비지도 학습(unsupervised learning) 방식을 이용한 이 실험은 사진에 전혀 표시를 하지 않고 입력한 사진만을 인공지능이 스스로 분석해 분류하는지 알아보는 실험이었다.

구글은 10억 개의 유튜브 창을 열어 무작위로 200×200픽셀의 캡처 화면 1000만 개를 만들어 3일간 인공지능을 학습시켰다.

그 결과, 인간의 얼굴은 81.7%, 인간의 몸은 76.7%, 고양이는 74.8%의 정확도로 인식에 성공했다.

기존의 머신러닝은 수많은 데이터가 있어야 학습이 가능했으나 이전의 학습내용을 활용해 적은 양의 데이터만으로도 인공지능 스스로 학습이 가능해졌다.

이러한 이미지 기반의 인공지능이 더욱 발전하게 된다면 카메라를 통해 사람을 인식하는 것 뿐 아니라 제스처나 표정을 통해 사용자의 의도를 파악할 수도 있다.

여기서 더욱 발전하게 되면 센서 인터페이스에 의한 인공지능으로 진화한다.

병원에 가서 어디가 아픈지를 말하는 것이 아니라 손목에 찬 스마트 워치나 액티비티 트래커(activity tracker)에 저장된 사용자의 심박수, 체온, 혈당, 혈압 등의 신체 데이터를 자동 전송하고 카메라나 스캐너로 신체를 스캔해 인공지능이 진단을 하는 날이 올 것이다.

인공지능과 인공지능의 대화는 단순히 재미삼아 이벤트로 하는 것이 아니다. 자동주행자동차를 예로 들면, 차를 운행하는 인공지능이 주변 차들에 탑재된 인공지능과 대화함으로써 사고 위험을 대폭 낮출 수 있다.

인공지능 발전의 끝은 어디일까? 영화 ‘2001 스페이스 오딧세이’에 나오는 ‘HAL 9000’, 일본 애니메이션 ‘공각기동대’에서 나오는 ‘인형사’. 영화 ‘I Robot’과 ‘터미네이터’에서 나오는 인공지능들은 자의식을 갖고 스스로를 존재로서 인식한다는 공통점이 있다.

인공지능이 궁극적으로 발전하게 되면 스스로 자의식을 가진 초지능이 된다. 시간이 얼마나 걸릴 것인가가 관건일 뿐 반드시 도래할 미래다. 초지능의 세상이 올 때까지 우리는 무엇을 준비해야 할 것인가.

<본 기사는 테크M 제46호(2017년 2월) 기사입니다>

-

보는 것이 이해하는 것...AI가 데이터 활용도 바꾼다새로운 창작환경이 시작됐다.디지털 카메라가 등장하고 그래픽 소프트웨어의 대중화가 우리의 창작환경을 변화시켰던 것처럼, 창작자들이 소프트웨어를 직접 개발하는 것을 넘어 학습을 통해 진화할 수 있는 지능적 창작 세계를 만들어 낼 수 있게 됐다. 이러한 변화는 창작자들에겐 아주 특별한 경험으로 다가오고 있다.바로 인공지능과 창작환경의 이야기다.창작자들은 기계학습을 통해 어떤 단계에 가중치를 두면특별한 창작물을 만들어 낼 수 있는지, 어떤 학습 데이터가 더 흥미로운 결과물을 만들어 낼 수 있는지 등 더 많은 창작적 시도를2017-02-27 16:00:05민세희 데이터 시각화 아티스트

보는 것이 이해하는 것...AI가 데이터 활용도 바꾼다새로운 창작환경이 시작됐다.디지털 카메라가 등장하고 그래픽 소프트웨어의 대중화가 우리의 창작환경을 변화시켰던 것처럼, 창작자들이 소프트웨어를 직접 개발하는 것을 넘어 학습을 통해 진화할 수 있는 지능적 창작 세계를 만들어 낼 수 있게 됐다. 이러한 변화는 창작자들에겐 아주 특별한 경험으로 다가오고 있다.바로 인공지능과 창작환경의 이야기다.창작자들은 기계학습을 통해 어떤 단계에 가중치를 두면특별한 창작물을 만들어 낼 수 있는지, 어떤 학습 데이터가 더 흥미로운 결과물을 만들어 낼 수 있는지 등 더 많은 창작적 시도를2017-02-27 16:00:05민세희 데이터 시각화 아티스트 -

[이슈 브리핑] 알리페이 참전한 간편 결제 대전…플랫폼화 속도가 관건알리페이가 카카오 페이와 손잡았다.카카오와 알리페이의 앤트파이낸셜서비스그룹이 지난 21일 핀테크 공동 사업을 위한 전략적 제휴를 맺었다. 알리페이의 모회사인 앤트파이낸셜은 카카오가 핀테크 사업부문을 분사해 설립한 카카오 페이에 2억 달러를 투자한다. 앤트파이낸셜과 카카오는 알리페이의 금융·커머스 네트워크와 카카오의 플랫폼을 결합해 한국내 핀테크 사업을 강화할계획이다. 올해 간편 결제 서비스 경쟁2라운드가 시작될 것으로 전망되는가운데 강력한 두 기업이 손을 잡음으로써핀테크 시장판도에 큰 변화가 예상된다.[테크M = 도강호2017-02-26 17:37:08도강호 기자

[이슈 브리핑] 알리페이 참전한 간편 결제 대전…플랫폼화 속도가 관건알리페이가 카카오 페이와 손잡았다.카카오와 알리페이의 앤트파이낸셜서비스그룹이 지난 21일 핀테크 공동 사업을 위한 전략적 제휴를 맺었다. 알리페이의 모회사인 앤트파이낸셜은 카카오가 핀테크 사업부문을 분사해 설립한 카카오 페이에 2억 달러를 투자한다. 앤트파이낸셜과 카카오는 알리페이의 금융·커머스 네트워크와 카카오의 플랫폼을 결합해 한국내 핀테크 사업을 강화할계획이다. 올해 간편 결제 서비스 경쟁2라운드가 시작될 것으로 전망되는가운데 강력한 두 기업이 손을 잡음으로써핀테크 시장판도에 큰 변화가 예상된다.[테크M = 도강호2017-02-26 17:37:08도강호 기자 -

음성에서 이미지, 센서로… AI 인터페이스의 변신인공지능에서 기술적으로 중요한 것은 사용자의 의도를 파악하고, 분석 결과를 사용자에게 전달하는 것이다.기업 입장에서는 인공지능이 사람을 대신해 효과적으로 고객과 커뮤니케이션 할 수 있는지가 중요하다.현재 인공지능은 대부분 음성 인터페이스 기반이다. 언어라는 커뮤니케이션이 가장 보편적이기 때문이다.이미지 기반의 인공지능이 발전하면 제스처나 표정을 통해 사용자의 의도를 파악할 수 있다. 또 센서 인터페이스에의한 인공지능으로 진화하면 스마트 워치에 저장된 사용자의 신체 데이터를 자동 전송하고 신체를 스캔해인공지능이 진단2017-02-26 14:18:38김석기 동양대학교 겸임교수

음성에서 이미지, 센서로… AI 인터페이스의 변신인공지능에서 기술적으로 중요한 것은 사용자의 의도를 파악하고, 분석 결과를 사용자에게 전달하는 것이다.기업 입장에서는 인공지능이 사람을 대신해 효과적으로 고객과 커뮤니케이션 할 수 있는지가 중요하다.현재 인공지능은 대부분 음성 인터페이스 기반이다. 언어라는 커뮤니케이션이 가장 보편적이기 때문이다.이미지 기반의 인공지능이 발전하면 제스처나 표정을 통해 사용자의 의도를 파악할 수 있다. 또 센서 인터페이스에의한 인공지능으로 진화하면 스마트 워치에 저장된 사용자의 신체 데이터를 자동 전송하고 신체를 스캔해인공지능이 진단2017-02-26 14:18:38김석기 동양대학교 겸임교수